- Nvidia Pazartesi günü, üretken AI patlamasını güçlendiren AI model türlerini eğitmek ve dağıtmak için tasarlanmış bir GPU olan H200’ü tanıttı.

- H200, AI modellerini kullanarak metin, resim veya tahmin oluşturmasına yardımcı olacak 141 GB yeni nesil “HBM3” belleğe sahiptir.

- Nvidia’nın yapay zeka destekli GPU’larına olan ilgi şirketin ivmesini artırdı ve satışların bu çeyrekte %170 artması bekleniyor.

Nvidia başkanı Jensen Huang, Computex 2023 sırasında Supermicro’nun açılış sunumunda üretken yapay zekada kullanılan Grace hopper çip CPU’sunu elinde tutuyor.

Velid Barazek | Roket Lite | Getty Images

Nvidia Pazartesi günü, üretken AI patlamasını güçlendiren AI model türlerini eğitmek ve dağıtmak için tasarlanmış bir GPU olan H200’ü tanıttı.

Yeni GPU, OpenAI’nin en gelişmiş büyük dil modeli GPT-4’ü eğitmek için kullandığı çip olan H100’ün bir yükseltmesidir. Büyük şirketler, start-up’lar ve devlet kurumları sınırlı miktarda çip tedariki için rekabet ediyor.

Raymond James, H100 çiplerinin maliyetinin 25.000 ila 40.000 dolar arasında olduğunu ve “eğitim” adı verilen bir süreçte en büyük modelleri oluşturmak için binlerce çipin birlikte çalışması gerektiğini tahmin ediyor.

Nvidia’nın yapay zeka destekli GPU’larına duyulan heyecan, şirketin 2023’te şu ana kadar %230’dan fazla artış gösteren hisselerini hızla yükseltti. Nvidia, üçüncü mali çeyrek için geçen yıla göre %170 artışla yaklaşık 16 milyar dolar gelir bekliyor.

H200’deki ana gelişme, çipin “buluşsal yöntem” gerçekleştirmesine veya metin, görüntü veya tahminler oluşturmak üzere eğitildikten sonra büyük bir model kullanmasına yardımcı olacak 141 GB’lık yeni nesil “HBM3” belleği içermesidir.

Nvidia, H200’ün H100’den neredeyse iki kat daha hızlı çıktı üreteceğini söyledi. Bu, Meta’nın Llama 2 LLM’si ile yapılan testlere dayanmaktadır.

2024 yılının ikinci çeyreğinde piyasaya sürülmesi beklenen H200, AMD’nin MI300X GPU’su ile rekabet edecek. H200’e benzeyen AMD çipi, öncüllerine kıyasla ek belleğe sahip ve bu da büyük modellerin çıkarım yapmak için donanıma sığmasına yardımcı oluyor.

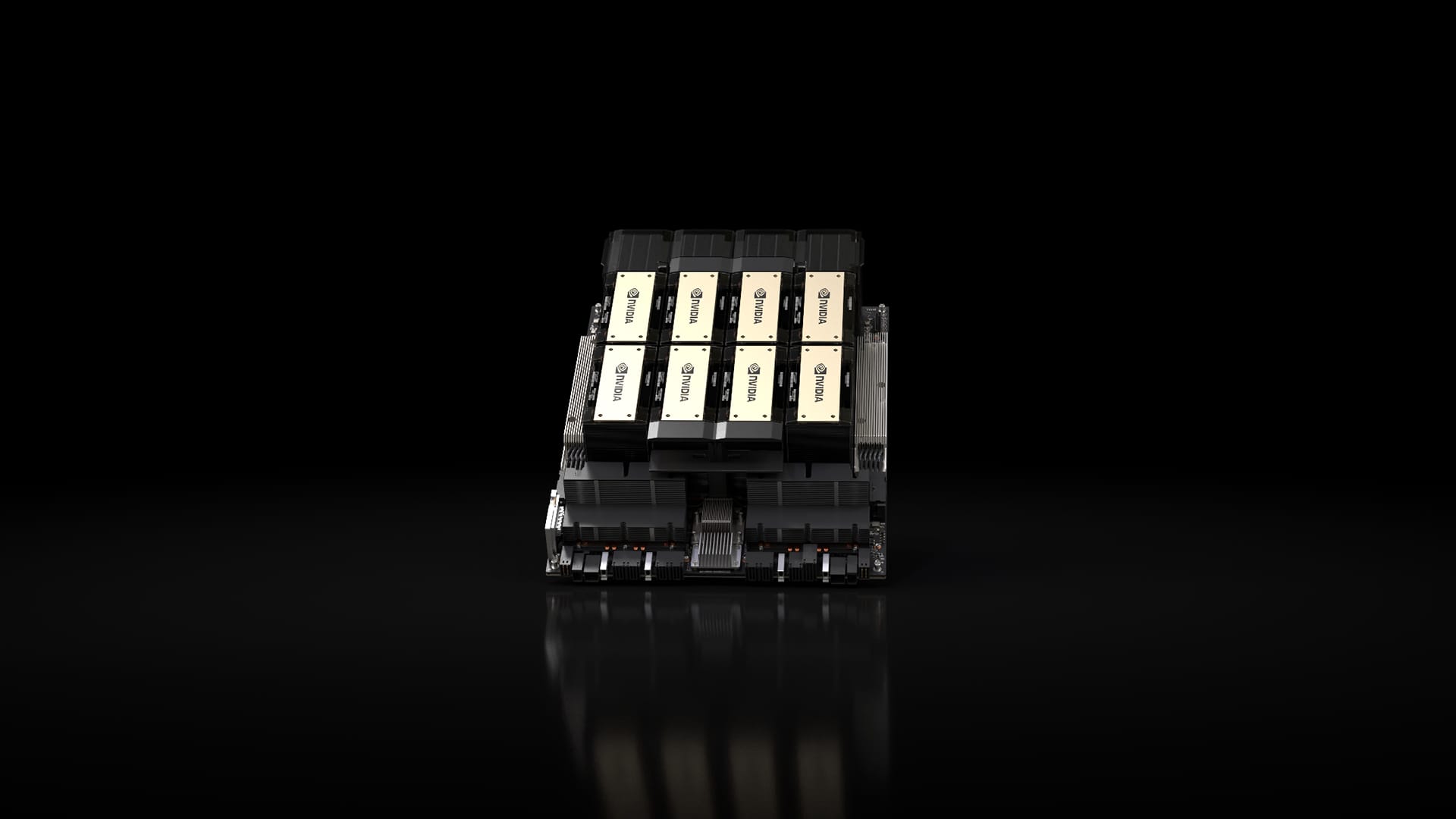

Sekiz GPU’lu Nvidia HGX sisteminde Nvidia H200 yonga seti.

Nvidia

Nvidia, H200’ün H100 ile uyumlu olacağını söyledi; bu da halihazırda önceki model üzerinde eğitim alan yapay zeka şirketlerinin yeni sürümü kullanmak için sunucu sistemlerini veya yazılımlarını değiştirmelerine gerek kalmayacağı anlamına geliyor.

Nvidia, şirketin tam HGX sistemlerinde dört GPU veya sekiz GPU sunucu yapılandırmasının yanı sıra, H200 GPU’yu Arm tabanlı bir işlemciye bağlayan GH200 adı verilen bir çipte bulunacağını söylüyor.

Ancak H200, en hızlı Nvidia AI çipi unvanını uzun süre elinde tutamayabilir.

Nvidia gibi şirketler çipleri için birçok farklı konfigürasyon sunarken, yeni yarı iletkenler genellikle her iki yılda bir, üreticilerin bellek eklemekten veya diğer küçük iyileştirmelerden daha önemli performans kazanımlarının kilidini açan farklı bir mimariye geçmesiyle büyük bir adım atıyor. H100 ve H200, Nvidia’nın Hopper mimarisini temel alıyor.

Ekim ayında Nvidia, yatırımcılara GPU’larına olan yüksek talep nedeniyle iki yıllık mimari süreçten bir yıllık sürüm modeline geçeceğini söylemişti. Şirket teklif etti Slayt önerileri Yaklaşan Blackwell mimarisini temel alan B100 çipini 2024 yılında duyuracak ve piyasaya sürecek.

İzler: Gelecek yıl başlayacak yapay zeka trendine güçlü bir şekilde inanıyoruz

CNBC PRO’nun bu hikayelerini kaçırmayın:

“Analist. Tutkulu zombi gurusu. Twitter uygulayıcısı. İnternet fanatiği. Dost pastırma hayranı.”

More Stories

Forbes, Illinois’in en zengin kişisini açıkladı – NBC Chicago

Yellen, yen yükseldikten sonra dövize müdahale konusunda dikkatli olunmasını tavsiye etti

Ethereum’un 35 Milyon Dolarlık Değişimi: ETH’nin %7 Artışı Nasıl 2 Ayın En Yüksek Seviyesine Ulaştı?